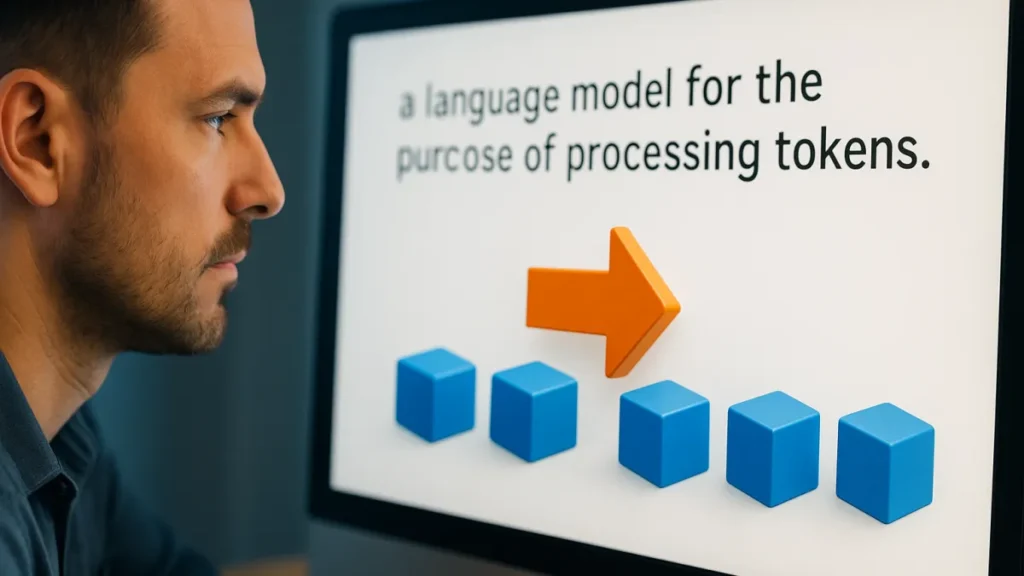

Entenda, de forma prática e direta, como a tokenização transforma texto em blocos que máquinas conseguem entender e processar.

Se você já trabalhou com processamento de linguagem ou experimentou modelos de IA, sabe que texto bruto não é suficiente. Para que algoritmos leiam, comparem e aprendam, o texto precisa ser convertido em unidades menores e consistentes. É aqui que entra a tokenização.

Neste artigo vou explicar, passo a passo, o que é tokenização, por que ela importa e como aplicá-la em tarefas comuns. Vou usar exemplos claros e dicas práticas para você sair daqui pronto para testar. Também vou mostrar ferramentas e cuidados comuns.

O que é Tokenização: Conversão de Texto em Unidades Processáveis

Tokenização é o processo de dividir texto em pedaços menores chamados tokens. Esses tokens podem ser palavras, subpalavras ou caracteres. O objetivo é transformar um fluxo de texto em elementos que um modelo pode manipular.

Quando falamos de Tokenização: Conversão de Texto em Unidades Processáveis, pensamos em duas fases: segmentação e codificação. Primeiro separemos o texto. Depois atribuímos números ou vetores a esses tokens.

Por que a tokenização é importante

Sem tokenização, modelos não entendem onde começa ou termina uma ideia. Isso afeta busca, classificação e geração de texto.

Tokenização: Conversão de Texto em Unidades Processáveis é a ponte entre linguagem humana e cálculos matemáticos. Ela determina como o modelo vê padrões, repete palavras e lida com erros de digitação.

Tipos comuns de tokenização

- Tokenização por palavra: divide o texto em palavras completas. Simples, mas frágil a palavras desconhecidas.

- Tokenização por subpalavra: quebra palavras em pedaços menores, útil para reduzir vocabulário e lidar com neologismos.

- Tokenização por caractere: cada caractere vira um token. Funciona para línguas sem espaços entre palavras, mas aumenta o comprimento da sequência.

Como funciona na prática: passos sequenciais

- Limpeza do texto: remover espaços extras e caracteres indesejados.

- Segmentação: dividir em tokens conforme a técnica escolhida.

- Normalização: transformar tudo em minúsculas ou aplicar lematização se preciso.

- Mapeamento: converter tokens em ids numéricos usando um vocabulário.

- Padding e truncamento: ajustar o tamanho das sequências para processamento em lote.

Exemplos reais

Suponha a frase: “O gato comeu.”

Com tokenização por palavra, você teria tokens: “O”, “gato”, “comeu”, “.”

Com subpalavras, “com” e “eu” talvez virassem tokens separados. Isso ajuda quando o modelo encontra “comeu” e também “comer”.

Erros comuns e como evitá-los

- Ignorar linguagem específica: Nem toda tokenização funciona bem para todas as línguas. Ajuste conforme o idioma.

- Vocabulário muito pequeno: Pode gerar muitos tokens desconhecidos.

- Padding excessivo: sequências muito longas desperdiçam memória. Revise o tamanho máximo.

Ferramentas e bibliotecas úteis

Existem bibliotecas bem testadas que oferecem tokenizadores eficientes. Elas tratam detalhes como subpalavras e vocabulário.

Entre as opções mais usadas estão tokenizadores que suportam várias estratégias e permitem treinar vocabulários próprios. Isso facilita quando seu domínio tem termos técnicos ou nomes próprios.

Dicas rápidas para escolher um tokenizador

- Compatibilidade: verifique se ele integra com seu modelo ou framework.

- Tamanho do vocabulário: escolha um equilíbrio entre cobertura e eficiência.

- Velocidade: teste processamento em lotes para ver o desempenho real.

Casos de uso práticos

Chatbots usam tokenização para entender perguntas e gerar respostas. Sistemas de busca indexam tokens para recuperar documentos relevantes.

Em classificação de sentimento, tokenização influencia diretamente a precisão. Pequenas mudanças no tokenizador podem alterar resultados.

Medindo impacto

Para avaliar a tokenização, compare métricas como acurácia, perda e tempo de inferência usando tokenizadores diferentes. Teste com dados reais do seu projeto.

Às vezes, uma tokenização mais simples funciona melhor em dados de fórum. Em textos técnicos, subpalavras tendem a reduzir erros por termos desconhecidos.

Checklist rápido antes de aplicar

- Entenda o idioma: considere regras específicas e sinais de pontuação.

- Avalie o vocabulário: calcule quantos tokens únicos surgem nos seus dados.

- Teste com amostras: veja como o tokenizador lida com abreviações e nomes próprios.

Agora você já tem um mapa prático para aplicar a tokenização no seu projeto. Lembre-se: Tokenização: Conversão de Texto em Unidades Processáveis não é apenas técnica, é parte da arquitetura que define como seu sistema verá o texto.

Se quiser testar rapidamente, escolha uma biblioteca, prepare um pequeno vocabulário e veja a diferença nos resultados. Para começar, volte para a página inicial e confira recursos que podem ajudar a implementar essas etapas. Tokenização: Conversão de Texto em Unidades Processáveis é uma habilidade que vale a pena praticar; aplique estas dicas hoje mesmo.